- info@linkblitz.dk

- 24/7 Online Support

Hurtig indeksering af hjemmesider på Google – den ultimative guide

Få din hjemmeside hurtigt indekseret på Google med denne komplette guide til hurtig indeksering. Lær hvordan du bruger Google Search Console, linkbuilding, hastighedsoptimering, AEO, GEO og tekniske SEO-tricks til at fremskynde Googles crawling og indeksering af dine sider.

Indholdsfortegnelse

Bliv fundet på Google - Sådan får du din nye hjemmeside hurtig indekseret

At få sin hjemmeside indekseret hurtigt på Google er afgørende for at blive synlig i søgeresultaterne. Som ny hjemmesideejer kan det være frustrerende at opleve, at dine sider ikke dukker op på Google med det samme. Indeksering (indexing) er den proces, hvor Google crawler (gennemsøger) dine sider og tilføjer dem til sit indeks – det store “bibliotek” af websites, som Google viser resultater fra.

Denne guide forklarer, hvorfor indeksering kan tage tid, og giver konkrete råd til, hvordan du fremskynder processen. Vi kommer omkring både organisk SEO, brug af Google Search Console, eksterne links, Core Web Vitals (hastighed), Google Ads-tricks, AEO (Answer Engine Optimization), GEO (lokal SEO) og vigtige tekniske aspekter. Målet er en grundig men letforståelig artikel, som både begyndere og erfarne SEO-folk kan få gavn af.

1. Organisk SEO og hurtig indeksering

Hvorfor vises en ny side ikke straks på Google?

Når du lancerer en ny hjemmeside eller tilføjer en ny side, vil den som udgangspunkt ikke være at finde på Google med det samme. Google skal først opdage siden, crawle den og vurdere indholdet, før den indekseres og kan rangere i søgeresultaterne. Denne proces kan variere fra få timer til flere uger. Især helt nye domæner eller sider uden links til sig kan være længe om at blive fundet. Det betyder, at selv hvis din side er offentlig på internettet, kan du opleve, at en Google-søgning ikke viser siden initialt. Det skyldes ikke en fejl – Google har simpelthen ikke registreret den endnu.

Intern linkstrukturens betydning

En af de mest effektive måder at hjælpe Google med at opdage nye sider er gennem intern linkstruktur. Google’s crawlere følger links fra side til side. Hvis din nye side er “forbundet” til resten af websitet via interne links, vil crawleren lettere finde den. Sørg for at linke til nye sider fra allerede indekserede og autoritative sider på dit website (f.eks. din forside eller andre populære undersider). En webcrawler bevæger sig netop fra link til link – interne links fungerer som veje der guider Google rundt på dit site. Hvis en ny side derimod ligger isoleret uden interne links (en såkaldt orphan page), er der stor risiko for, at Google overser den indtil du selv indsender den. Har du mulighed for det, kan et HTML- sitemap (en side der lister alle dine sider) også hjælpe: hver gang Google crawler dit site, vil den via sitemappet få et overblik og opdage nye URLs hurtigere.

Kort sagt – tænk intern linkstruktur ind fra start, og link nye vigtige sider frem så de ikke gemmer sig dybt nede uden indgående links.

Opdatering af indhold og “friskhed”

Googlebot besøger din hjemmeside med jævne mellemrum. Hvor ofte, afhænger bl.a. af hvor ofte der kommer nyt indhold. Hvis du løbende opdaterer din hjemmeside med frisk indhold – fx nye blogindlæg, produkter eller nyhedssider – vil Google opdage, at websitet er aktivt, og botten vil komme oftere forbi. Når Googlebot ser nyt indhold, bliver det indekseret og kan dermed blive synligt i søgeresultaterne. En hjemmeside der ikke er opdateret i lang tid, vil derimod blive crawlet sjældnere. Derfor er kontinuerlig opdatering en fordel: Det giver brugerne nyt indhold og holder Google interesseret i dit site. Overvej at lave en content-plan hvor du jævnligt udgiver relevant indhold; det kan både øge chancen for hurtigere indeksering og generelt styrke din organiske SEO. Samtidig kan du ved opdateringer linke til dine vigtigste sider, så de igen bringes top-of-mind for både brugere og søgemaskiner.

2. Google Search Console

Google Search Console (GSC) er et uundværligt gratis værktøj fra Google, som lader dig overvåge og påvirke hvordan Google ser dit website. For hurtig indeksering er der to funktioner, du især skal kende: URL Inspection Tool (URL-inspektionsværktøjet) og Sitemaps.

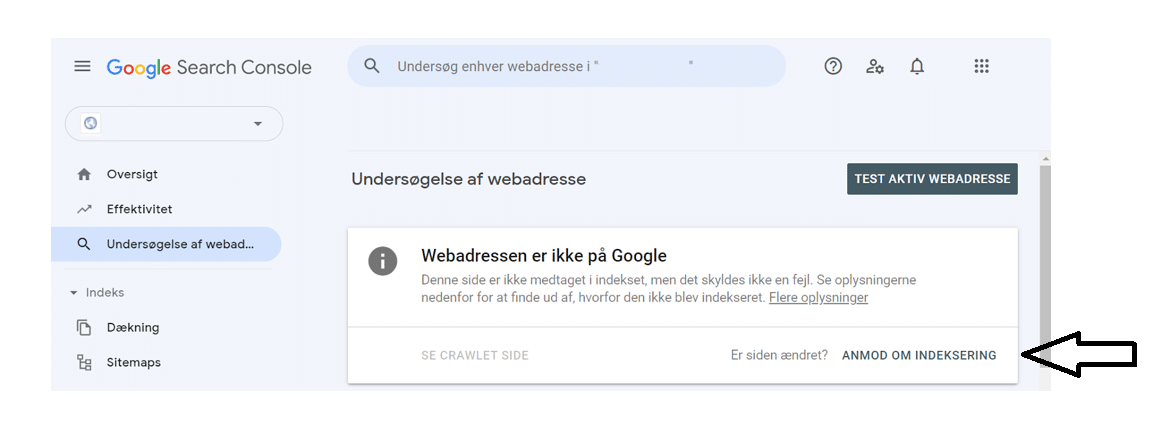

Anmod om indeksering af en side

URL Inspection: Anmod om indeksering af en side: Med URL-inspektionsværktøjet kan du se, om en specifik side er indekseret af Google – og hvis ikke, selv anmode om indeksering. Dette er ideelt for nye sider eller opdateret indhold, som du gerne vil have Google til at opdage hurtigt. Processen er simpel: Log ind på Search Console, vælg din ejendom (dit website), og indsæt den fulde URL til din side i søgefeltet øverst hvor der står “Undersøg enhver webadresse…”. Tryk Enter, og GSC vil hente status for URL’en. Hvis siden ikke allerede er indekseret, vil du se beskeden “Webadressen er ikke på Google” sammen med årsager (f.eks. “URL ikke fundet” eller andre oplysninger). Du får her muligheden for at klikke på knappen “Anmod om indeksering”.

Når du gør det, vil Google foretage en hurtig live-test for at tjekke, at siden kan crawles (ingen blokeringer). Herefter får du en bekræftelse på, at URL’en er tilføjet en prioriteret crawl-kø. Det betyder, at du har “inviteret” Googles søgerobot – typisk vil siden blive crawlet og (hvis alt er i orden) indekseret inden for relativt kort tid, nogle gange få timer eller et par dage.

Bemærk: Der er en grænse for, hvor mange URL’er du kan anmode om per dag (Google giver fx en CAPTCHA hvis man gør det for hyppigt, og en kvote på måske ~10 URL’er dagligt).

Brug derfor funktionen for dine vigtigste sider – for store websites med mange nye sider bør du i stedet indsende et sitemap eller vente på naturlig crawling.

Tip: Hvis du har rettet et indeksproblem (fx fjernet et noindex-tag), kan du også bruge “Anmod om indeksering” for at få Google til at gen-crawle siden hurtigt.

Indsend et sitemap.xml

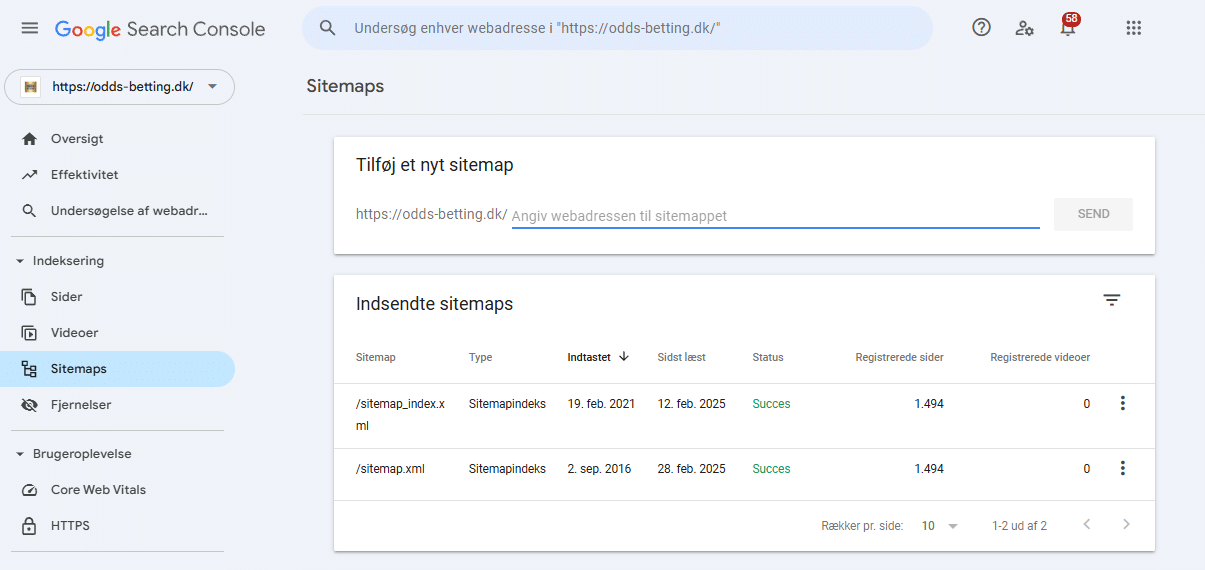

Et sitemap er en XML-fil, der indeholder en liste over alle (eller udvalgte) sider på dit website, typisk fundet på dinhjemmeside.dk/sitemap.xml. Sitemappet hjælper søgemaskiner med at opdage dine URLs mere effektivt. I Google Search Console kan du aktivt indsende dit sitemap, hvilket er næste skridt mod hurtigere indeksering.

Navigér i Google Search Console til menuen “Indeks > Sitemaps”. Her ser du en boks med “Tilføj et nyt sitemap”. Indtast stien til din sitemap-fil (fx sitemap.xml eller sitemap_index.xml afhængigt af dit CMS) i feltet og klik Send. Når du har indsendt sitemappet, vil Google validere det og begynde at hente de URL’er det indeholder. Fordelen ved at indsende sitemap er, at du fortæller Google om alle dine sider på én gang i stedet for at vente på, at den selv finder dem via links. Især for nye hjemmesider med få indgående links er sitemap vigtigt, da Google ellers kan overse enkelte undersider. I Search Console vil du under Sitemaps kunne se status (fx “Succes”) og hvor mange webadresser der er indsendt og indekseret via sitemappet. Når først dit sitemap er indsendt, overvåger Google det løbende – hvis du tilføjer nye sider, vil de dukke op i sitemappet, og Google vil opdage dem ved næste crawl af sitemappen.

Husk at mange CMS-systemer (som WordPress med Yoast eller RankMath SEO-plugin) automatisk genererer sitemap og endda ping’er Google, når det opdateres. Alligevel bør du selv indsende det i GSC som ekstra sikkerhed. Sitemappet erstatter dog ikke andre metoder – du bør stadig lave interne links osv. – men det er et fundamentalt skridt.

Hvordan ser processerne ud?

Ovenfor har vi med skærmbilleder illustreret de to vigtige GSC-funktioner. Første skærmbillede viser URL-inspektion: her er siden ikke indekseret og der er en knap til at anmode om indeksering. Andet skærmbillede viser Sitemaps-siden efter at et sitemap er indsendt. Som det fremgår, giver Search Console dig værdifuld indsigt – du kan altid se om en side er i Googles indeks, hvornår den sidst er crawlet, og om der evt. er fejl (fx blokeringer) der forhindrer indeksering. Brug GSC aktivt: Udover indeksering kan du fx også se “Dækning”-rapporten for at tjekke hvilke sider der er indekseret eller ekskluderet, og hvorfor. I denne sammenhæng er URL-inspektion og sitemaps dog de vigtigste redskaber til at fremskynde selve indekseringen af nye sider.

3. Eksterne faktorer og omtale

Google finder ikke kun sider via dit eget site – den opdager også nye sider gennem eksterne links. Derfor spiller eksterne faktorer en rolle for, hvor hurtigt din side bliver indekseret.

Links fra andre websites

Når en ekstern side linker til din, kan Google støde på dit indhold gennem dette link. Særligt links fra “stærke” sider – dvs. sider der allerede er hyppigt crawlet af Google og har høj autoritet – kan give din nye side et boost ift. hurtig opdagelse. Et klassisk trick blandt SEO-folk er fx at poste et link til en ny artikel på et populært forum, en nyhedsside eller sociale medier med åben adgang. Fordi disse platforme gennemsøges ofte, vil Googles crawler sandsynligvis følge linket til din nye side næste gang den er dér.

Sociale medier kan også hjælpe: Twitter er et godt eksempel. Google har (siden en aftale i 2015) adgang til at crawle offentlige tweets i nogen grad, så hvis du tweeter et link til din nye side, kan det bidrage til at Google opdager den. Hvis du har en aktiv Twitter-konto, er det altså værd at dele nye links dér. Vær dog opmærksom på, at Facebook ikke er lige så effektiv til dette formål – meget indhold på Facebook er privat eller kræver login, så Googlebot kan som udgangspunkt ikke følge med (med mindre du har en helt åben profil eller side). LinkedIn, Reddit, Pinterest og andre offentligt indekserbare tjenester kan ligeledes bruges til at smide et link og skabe “omtale” af din side. Udover at hjælpe indeksering giver det også potentielle besøgende en chance for at finde dit indhold.

Link building for hurtigere indeksering

Udover de hurtige delinger på sociale medier, bør du også tænke mere langsigtet omkring link building. Link building – at skaffe sig backlinks fra andre hjemmesider – er mest kendt for at løfte rankings (placeringer) i Google. Men det spiller også en rolle for indeksering. Et website med mange kvalitative indgående links vil generelt blive crawlet oftere og dybere af Google. Og hvis din nye side allerede fra start har et par gode backlinks, vil Googles edderkop (crawler) hurtigere finde frem til den. Overvej derfor strategier som: gæsteindlæg på andre blogs (hvor du kan linke til dit site), tilmelding af din side i relevante kataloger/virksomhedsregistre, eller omtale i pressen. Selv et par enkelte links kan gøre en forskel i, om din side bliver opdaget inden for 1-2 dage i stedet for 1-2 uger. Kvalitet er dog vigtigere end kvantitet – 1 link fra en troværdig relevant side er mere værd end 10 links fra obskure kilder. Lav heller ikke spam-agtige links kun for indekseringens skyld, da det på sigt kan skade din SEO.

Pro tip: Har du allerede andre hjemmesider eller blogs, kan du derfra linke til den nye side. Eller måske har du partnere/kontakter med websites, der vil linke til dig. Alle disse eksterne signaler fungerer som “henvisninger”, der peger Googlebot i retning af dit indhold.

Omtale og trafik

Ud over links kan selve omtale af dit brand eller side på nettet samt tidlig trafik hjælpe indirekte. Forestil dig, at din nye side får besøgende via sociale medier – hvis de bruger Chrome-browseren, kan deres aktivitet potentielt blive en del af de signaler Google ser (Chrome sender noget anonymiseret data tilbage, som bl.a. bruges i statistik som Core Web Vitals, hvilket vi kommer til). Uanset hvad kan en tidlig strøm af besøg (om så de kommer via annoncer, sociale medier eller nyhedsbreve) indikere over for Google, at siden er populær eller i det mindste aktiv, og det kan animere Googlebot til at crawle. Derfor: når du lancerer nyt indhold, så gør omverdenen opmærksom på det. Del det, tal om det, få andre til at nævne det. Det værste du kan gøre for indeksering er at lave en ny side og så lade den stå helt isoleret uden hverken links eller omtale – så skal Google gætte sig til at den findes, hvilket kan tage meget lang tid.

4. Core Web Vitals og hastighedsoptimering

Google belønner hjemmesider, der giver en god brugeroplevelse – og et vigtigt aspekt af brugeroplevelsen er hastighed. Faktisk er sidehastighed og såkaldte Core Web Vitals officielle ranking-faktorer i Google’s algoritme (omend mindre faktorer sammenlignet med relevans). Men hvorfor nævner vi det i en artikel om hurtig indeksering? Fordi optimering af hastighed ikke alene forbedrer din placering, men også indirekte kan påvirke indeksering:

For det første vil en hurtig side typisk blive crawlet mere effektivt. Google opererer med noget kaldet “crawl budget”, der groft sagt er den mængde tid og ressourcer Googlebot bruger på dit site. Hvis dine sider loader ekstremt langsomt, kan Googlebot nå færre sider per besøg, og det kan forsinke hvor ofte (og hvor dybt) den kommer rundt. En hurtig side gør Googles arbejde nemmere. For det andet ønsker Google at vise brugerne sider, der loader hurtigt og stabilt – derfor prioriteres hurtige sider i søgeresultaterne.

Selvom dette primært handler om ranking efter at siden er indekseret, kan man argumentere for, at Google er mere ivrig efter at indeksere indhold som de anser for høj kvalitet – og brugeroplevelse (herunder hastighed) er en del af kvalitetsvurderingen.

Core Web Vitals er en samling af hastigheds- og brugeroplevelsesmetrics, som Google især fokuserer på:

- LCP (Largest Contentful Paint): måler hvor lang tid der går, før det primære indhold er indlæst. Skal helst være under 2,5 sek (på mobil).

- FID (First Input Delay): måler interaktivitet – hvor lang tid før siden reagerer på første brugerinput. Skal være under 100 ms.

- CLS (Cumulative Layout Shift): måler visuel stabilitet – om layoutet flytter sig under indlæsning. Skal være under 0,1.

Hvis disse tre metrics er “grønne” (god status), anser Google sideoplevelsen for god. Google Search Console har endda en rapport for Vigtige netstatistikker (Core Web Vitals), hvor du kan se hvilke sider der eventuelt halter. Som tommelfingerregel: hurtigere er bedre, især på mobil og under langsommere forbindelser.

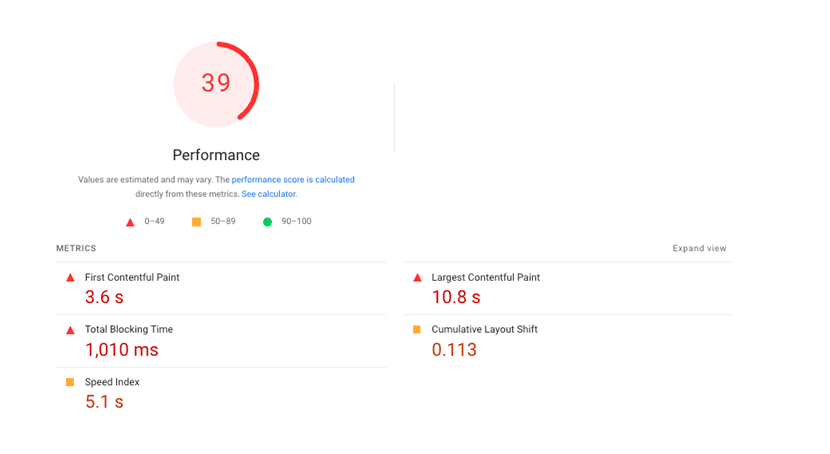

Test din hastighed med PageSpeed Insights

For at optimere hastighed skal du først vide, hvor du står. Googles eget værktøj PageSpeed Insights (PSI) er et godt udgangspunkt. Du indtaster blot din URL på siden pagespeed.web.dev (eller via developers.google.com) og kører en analyse. PSI giver dig to slags data: feltdata (hvis tilgængeligt, fra rigtige brugere via Chrome UX Report) og lab-data (en Lighthouse-test, der simulerer indlæsning under visse forhold). Du får en samlet Performance score fra 0-100, farvekodet (rød/gul/grøn), og du får specifikke metric-værdier for bl.a. FCP, LCP, Speed Index, TBT og CLS. Derudover lister værktøjet diagnostik og forslag til forbedringer. Du kan f.eks. se om billeder kan optimeres, om der er CSS/JS der blokerer rendering, om server-responstiden er for høj osv. Brug disse anbefalinger målrettet: Nogle typiske hastighedsoptimeringer er at komprimere og dimensionere billeder korrekt, minificere og sammenlægge CSS/JS filer, bruge browser caching og Content Delivery Networks (CDN), fjerne unødvendige scripts, og sikre en hurtig server/responstid. Start med de “lavthængende frugter” som PSI viser.

Google favoriserer hurtige sider

Som nævnt belønnes sider der loader hurtigt. Google har udtalt, at hvis dine Core Web Vitals alle er “grønne”, kan det give et lille ranking-boost. Omvendt, hvis din side er meget langsom (specielt på mobile enheder), kan det skade din placering – og brugerne vil måske opgive at vente, selv hvis du dukker op. Sørg derfor for, at hastighedsoptimering er en integreret del af din SEO-strategi. Du kan tjekke dine Core Web Vitals data i Google Search Console under “Vigtige netstatistikker” for en samlet oversigt over URL’er på dit domæne. Husk også at test på rigtige enheder – PageSpeed Insights simulerer fx en mid-range telefon på 4G. Prøv selv at åbne siden på en telefon med almindeligt 4G for at få en fornemmelse.

Afslutningsvis skal det understreges, at hastighedsoptimering ikke i sig selv indekserer din side hurtigere; men det sikrer at når Google kommer, så kan den nemt tilgå indholdet, og at din side har de bedst mulige forudsætninger for at klare sig godt i søgeresultaterne efter indeksering. En hurtig, teknisk sund side + godt indhold = højere crawl rate og bedre placeringer i det lange løb.

5. Google Ads og hurtigere indeksering

Kan en Google Ads-kampagne virkelig hjælpe med hurtigere indeksering? Det lyder måske kontraintuitivt – Ads handler jo om betalt trafik, ikke organisk søgning. Men der er et par måder, hvorpå Google Ads indirekte kan skubbe til indekseringsprocessen.

Annonce-crawl af landingsider

Når du opretter en annonce i Google Ads, skal du angive en landingsside (den URL som brugerne kommer ind på ved klik). Google ønsker at sikre, at annoncens landingsside er relevant og ikke i strid med retningslinjerne. Derfor vil Googles Ads-bot (en variant af Googlebot) ofte besøge og crawle landingssiden kort efter at annoncen er oprettet eller løbende under kvalitetsvurderingen. Dette crawl ligner til forveksling en almindelig Googlebot-crawl. Det vil sige, at hvis du har en spritny side og du sætter en Google Ads-annonce op, vil Google automatisk opdage siden via annoncegennemgangen. Ofte vil den også indeksere siden til organisk søgning som et resultat heraf – ikke fordi du “betaler for indeksering”, men fordi Google nu kender siden og har crawlet den. Du kan således benytte en mini-Ads kampagne som en slags “fast track” for at få Google til at besøge din nye side.

Trafik og brugerfeedback

Derudover, hvis din annonce kører, får du (forhåbentlig) noget trafik ind på din nye side. Som nævnt tidligere kan rigtig brugertrafik skubbe lidt til indekseringen – især hvis mange besøger siden og måske bliver der et stykke tid (lav bounce rate, høj dwell time), så er det et positivt signal om sidens kvalitet. Google benægter officielt at bruge Google Analytics data eller lignende til indeksering/ranking; men indirekte kan populært indhold tiltrække sig mere opmærksomhed. Under alle omstændigheder får du med Ads noget aktivitet på siden fra dag ét.

Praktisk fremgangsmåde: Hvis du vil prøve dette trick, behøver det ikke være dyrt. Du kan oprette en lille search-campaign eller endda en display-annonce med en meget lav dagsbudget (fx 50 kr om dagen) og lade den køre et par dage. Vælg nogle meget relevante søgeord for siden (så du også får kvalificeret trafik) eller målret en publikum for display. Når kampagnen er aktiv, hold øje med Search Console – du vil sandsynligvis se, at Google indekserer siden relativt hurtigt. Husk, kvalitetsindhold er stadig afgørende; Ads hjælper kun med at opdage siden, ikke med at ranke den godt organisk.

Advarsel: Dette er ikke en officiel “garanteret” metode, men mange SEO-specialister har haft gode erfaringer med den. Det er heller ikke en langtidsstrategi – du bør ikke betale for annoncer kun for indeksering i det lange løb. Men til lancering af en ny vigtig side (f.eks. en stor produktlancering, kampagneside eller ny stor artikel) kan et kort Ads-burst kickstarte synligheden. Og uanset hvad får du nogle besøgende og måske værdifuld data om, hvordan de interagerer med siden.

Afslutningsvis – Google Ads kan ikke købe dig en topplacering i det organiske indeks. Men det kan være et smart supplement til at sikre, at Google får øje på dit nye indhold med det samme, i stedet for at du skal gå og vente. Overvej om investeringen står mål med gevinsten for dit specifikke tilfælde.

6. Answer Engine Optimization (AEO) og GEO (Geographical Optimization)

Udtrykkene AEO og GEO er nyere begreber inden for søgemaskineoptimering, som henholdsvis handler om optimering til direkte svar og optimering til geografiske søgninger. Disse områder adskiller sig lidt fra traditionel SEO, men de spiller en rolle i den overordnede synlighed og hvordan dit indhold bliver fundet og brugt.

Hvad er AEO?

AEO står for Answer Engine Optimization – altså “svar-motor-optimering”. Hvor traditionel SEO fokuserer på at forbedre din placering på en søgemaskines resultatside (SERP), fokuserer AEO på at få dit indhold til at fremstå som selve svaret på brugerens forespørgsel. Med fremkomsten af stemmesøgning (voice search) og AI-assistenter som Siri, Google Assistant m.fl., stiller brugerne i stigende grad spørgsmål i komplet sprog og forventer at få direkte svar tilbage, snarere end en liste af links. AEO handler om at optimere indhold, så det kan levere disse direkte svar. Det vil sige, at dit indhold struktureres og skrives på en måde, så søgemaskiner (eller “svarmotorer”) nemt kan trække et konkret svar ud.

Hvordan adskiller det sig fra SEO? Traditionel SEO vil fx optimere en side til at ranke på “hvordan binder man en slipseknude” og så håbe at brugeren klikker på linket for at læse guiden. AEO vil derimod optimere indholdet, så Google måske allerede på resultatsiden viser selve instruktionen (f.eks. i et featured snippet). I voice search scenario ville Google Assistant måske læse svaret højt fra dit site, uden at brugeren besøger siden. AEO omfavner denne udvikling. Nøgleelementer i AEO inkluderer:

- Struktureret indhold og skema-markup: Ved at bruge schema (f.eks. FAQPage, HowTo, Q&A markup) kan du hjælpe Google med at forstå spørgsmål/svar på din side

. Struktur gør det lettere for søgemaskinen at identificere “her er spørgsmålet, her er svaret”.

- Præcise og koncise svar: Indholdet skal levere værdi hurtigt. Hvis du kan besvare et ofte stillet spørgsmål i første afsnit med ~50-100 tegn klart og tydeligt, øger det chancen for at Google vælger dit svar til fx en featured snippet. Lav evt. en FAQ-sektion på siderne med spørgsmål formuleret som brugerne ville stille dem, efterfulgt af direkte svar.

- Naturligt sprog og long-tail keywords: Da mange stiller spørgsmål med almindeligt talesprog (især via stemmeassistenter), optimer efter lange søgefraser og spørgsmål. Inkludér spørgsmål som overskrifter (H2/H3) og besvar dem lige under. Tænk over brugerens søgeintention – hvad er det præcise informationsbehov? AEO kræver at du rammer plet, ikke bare lokker klik.

- Autoritet og troværdighed: Selvom brugeren måske ikke klikker ind, vil Google kun bruge dit indhold som svar, hvis det stoler på kvaliteten. E-A-T-principperne (Experience, Expertise, Authoritativeness, Trustworthiness) gælder stadig. Sørg for fakta er korrekte, og giv om muligt reference (f.eks. kildehenvisninger), så maskinen og brugeren anser svaret for pålideligt.

Et eksempel på AEO: Hvis en bruger spørger sin telefon “Hvor gammel er Dronning Margrethe?”, vil Google ikke vise 10 blå links – den vil forsøge at svare: “Dronning Margrethe den Anden er 83 år gammel” og måske nævne kilden. Hvis du drev en biografi-hjemmeside, ville AEO-optimering bestå i at have en sætning der klart formulerer fødselsdato og nuværende alder, så Google kunne bruge den. AEO er med andre ord arbejdet med at tilpasse dit indhold til søgemaskinernes nye rolle som “svarleverandører” fremfor bare “søgeresultat-leverandører”. Som SEO-specialist bør du altså tænke i at skabe content, der ikke bare rangér godt, men også direkte besvarer de spørgsmål din målgruppe stiller.

AEO er en forkortelse for “Answer Engine Optimization” og har til formål – som navnet så indiskret afslører – at forsyne dig med et svar på din søgeforespørgsel. (Med andre ord, AEO skal sikre, at brugeren får præcis det svar vedkommende søger, hurtigt og uden at skulle klikke sig gennem flere links.)

Tips til AEO-optimering af indhold:

– Brug spørgsmål og svar-formatet aktivt i din tekst (fx FAQ-sektioner).

– Implementér Schema markup for FAQs, How-to guides, osv., så dit indhold kan fremhæves i “People also ask” eller som uddrag.

– Skriv klart og undgå overflødigt fyld i de afsnit, der besvarer spørgsmål. Tænk: “Ville denne sætning give mening hvis den blev læst højt som svar?” Hvis ja, er du på rette vej.

– Test ved at Google nogle af de spørgsmål du forsøger at besvare. Hvis Google allerede giver et snippet-svar fra en konkurrent, se hvordan de formulerer det og hvad du kan gøre bedre eller mere præcist.

Hvad er GEO?

GEO står for Geographical Optimization. I praksis handler det om lokal SEO – altså at optimere dit website og online tilstedeværelse til lokale søgeresultater. Lokal SEO er enormt vigtigt for virksomheder, der servicerer et bestemt geografisk område (tænk: håndværkere, restauranter, fysiske butikker, lokale serviceydere). Når en bruger laver en søgning med lokal intention – f.eks. “pizzeria i Odense” eller bare “tømrer” (hvor Google via brugerens lokation forstår, at der menes i nærheden) – så ændres søgelandskabet markant. Google viser typisk et lokalt pack/kort med Google Maps lister (Google My Business profiler), og rangordningen påvirkes af andre faktorer end ved generelle søgninger.

Geographical Optimization indebærer:

- Google My Business (Google Virksomhedsprofil): At oprette og optimere din virksomhedsprofil på Google er nok det vigtigste skridt i lokal SEO. Her angiver du din adresse, åbningstider, telefon, website og kan få anmeldelser. En fuldt udfyldt og verficeret GMB-profil gør, at du kan dukke op i Google Maps-resultater og i det lokale 3-pack på relevante søgninger.

- NAP-konsistens: NAP står for Name, Address, Phone number. Sørg for, at dit firmanavn, adresse og telefon er konsekvent angivet på tværs af alting – dit website, din GMB, eventuelle online kataloger (CVR, Krak, Facebook, etc.). Konsistens styrker troværdigheden af dine lokaloplysninger over for Google.

- Lokaliseret indhold: På dit website kan du lave indhold, der er målrettet specifikke byer eller områder, hvis det giver mening. Fx cases fra lokalområdet, blogindlæg om lokale emner, landingssider for hver by du servicerer (forsigtigt – de skal have unikt indhold, ikke bare gentaget keyword-stuffing). Som Bonzer beskriver: “Lokal SEO handler om at optimere hjemmesider til at ligge højere… på geografiske søgninger”, dvs. søgninger hvor sted indgår eller underforstås. Det kan både være eksplicitte stednavne-søgninger (“tandlæge Østerbro”) eller søgninger fra en lokal IP, hvor Google viser lokale resultater.

- Lokal link building og citationer: Få links og omtaler fra lokale aviser, blogs, foreninger, leverandører osv. Lokale citations (dit firmanavn + adresse nævnt) på andres sider kan hjælpe Google med at knytte din virksomhed til området.

- Anmeldelser: Skaf positive anmeldelser på din Google-profil (og evt. Facebook, Trustpilot m.v.). Brugere ser på stjerner, og der er tegn på at Google’s lokale algoritme belønner virksomheder med mange gode anmeldelser ved at give dem bedre synlighed. Hav også en strategi for at svare på anmeldelser – det viser aktivitet.

For indekseringens vedkommende vil en korrekt opsat Google My Business profil også sikre, at dit website-link derfra bliver crawlet (hvis dit website er nyt). Derudover kan lokaloptimering påvirke hvordan du bliver indekseret. For eksempel, hvis du har flersprogede eller fler-regionale sider, skal du bruge hreflang-tags og måske landedomæner for GEO-targeting. I Search Console kan du (for .com eller andre gTLD) angive hvilket land du primært målretter under “International målretning”. For .dk-domæner er det givet at det er DK.

Kort sagt, GEO optimering sikrer at lokale søgninger finder dig. Hvis din målgruppe er lokal, skal dit SEO-arbejde tilpasses det: Du vil gerne både dukke op i det organiske indeks og på Google Maps for dit område. Mange af disse tiltag påvirker ikke indekseringshastigheden i sig selv, men de påvirker hvordan du bliver præsenteret, og om du bliver synlig for de brugere der betyder mest for din forretning.

7. Tekniske aspekter (robots.txt, meta tags, canonical tags m.m.)

En sidste vigtig del af hurtig indeksering – og SEO generelt – er at have styr på de tekniske indstillinger, der kan påvirke, om Google overhovedet må eller vil indeksere din side. Her kigger vi på elementer som robots.txt, meta-robots tags og kanoniske tags, samt hvad du bør gøre med dem.

Robots.txt

Dette er en fil placeret i roden af dit domæne (dinhjemmeside.dk/robots.txt), som fortæller søgemaskinernes crawlere hvilke dele af siden de må eller ikke må tilgå. En typisk robots.txt indeholder Disallow-regler for sider eller mapper, man ikke ønsker crawlet (f.eks. admin-områder, scripts, interne søgesider osv.). For indeksering er det altafgørende, at du ikke ved en fejl blokerer vigtige sider i robots.txt. En fejlkonfigureret robots.txt, der fx indeholder Disallow: / (blokering af hele sitet) eller blokering af /blog/ mappen, kan fuldstændig forhindre Google i at se dit indhold. Hvis en side er blokeret i robots.txt, vil Googlebot slet ikke læse den – og dermed heller ikke indeksere dens indhold (den kan i nogle tilfælde indeksere URL’en hvis den finder den andetsteds, men uden indhold, hvilket ikke er ønskværdigt). Løsning: Tjek altid din robots.txt når du lancerer nyt site eller nye sektioner. Sørg for at dine primære sider ikke er under noget disallow. Standard for de fleste er at have alle offentlige sider åbne, og kun blokere irrelevante ting (som /wp-admin/ på WordPress etc.). Du kan teste din robots.txt via GSC’s “Robots.txt-tester” (i den gamle version af GSC) eller blot ved at besøge URL’en i en browser. Justér filen efter behov – ændringer træder i kraft med det samme for kommende crawls.

Meta-robots (index/noindex)

Udover den overordnede robots.txt har hver side mulighed for i sit HTML <head> at inkludere en meta-tag der instruerer crawlere om indeksering. Det typiske er: <meta name="robots" content="index, follow"> som betyder “indexér denne side og følg dens links” – dette er default, så ofte udelades meta-tag helt for sider der gerne må indekseres. Men hvis der står noindex, så beder siden direkte om ikke at blive indekseret. Mange CMS’er giver mulighed for at markere en side som “noindex” hvis den ikke skal vises (f.eks. hvis det er tyndt indhold, du vil undgå duplicate content, eller kun medlemmer skal finde den). Problemet opstår, når folk glemmer at ændre denne indstilling. Et klassisk eksempel: En udvikler-site eller staging-site har måske sat hele sitet til noindex mens det var under udvikling – når siden går live, glemmer man at fjerne noindex. Resultat: Google crawler siden (den er ikke blokeret i robots), men ser meta name=‟robots‟ content=‟noindex‟ og udelukker siden fra indekset. I Search Console vil du så se siderne under “Ekskluderet > Som følge af ‘noindex’-tag”. For hurtig indeksering skal du altså sikre dig, at dine sider ikke ved en fejl er markeret som noindex. Tjek især dette ved ny-launch. I WordPress er der fx en indstilling “Vis denne side til søgemaskiner” (eller omvendt “Discourage search engines”) – den skal slås til for at sitet indekseres. Som tommelfingerregel: Offentlige sider = bør være index, follow. Kun sæt noindex på sider du bevidst vil holde ude (som fx takkesider efter en form, duplicate paginerings-sider, interne søgninger osv.). Meta-robots tagget kan også styre follow/nofollow (om crawler må følge links på siden) – som udgangspunkt lad det være “follow”, da Google gerne må udforske dine links.

Canonical tags

Et kanonisk tag (link rel=‟canonical‟) angiver den foretrukne URL for en sides indhold, hvis det findes i flere varianter. Dette hjælper med at bekæmpe duplicate content. For eksempel, din side kan være tilgængelig på både http:// og https://, eller med og uden www., eller en shop kan have samme produkt under to kategorier med forskellige URL-parametre. Canonical-tagget i <head> peger på den “kanoniske” (oprindelige) version, som Google bør indeksere. Ift. hurtig indeksering skal du være opmærksom på, at forkert brug af canonical kan forhindre indeksering af den version, du ønsker. Hvis din nye side af en eller anden grund peger canonical til en anden side, vil Google tro, at indholdet er duplikeret og allerede indekseret andetsteds, og derfor springe over den. Typisk håndterer CMS’er canonical automatisk (f.eks. WordPress med Yoast sætter canonical til sidens egen URL). Men tjek det alligevel: i kildekoden for din side, find <link rel="canonical" href="..."> og se om href er sidens egen URL. Hvis ikke, skal det rettes. Et eksempel: Nogle gange kopierer folk en side som template og glemmer at ændre canonical, så den nye side peger canonisk til den gamle – så vil kun den gamle figurere i Google. Bottom line: Hver side, du vil have indekseret, bør pege canonisk på sig selv (eller i få tilfælde, slet intet canonical-tag hvis usikker).

Andre meta-tags

Ud over meta-robots kan meta-tags som <meta name="description"> være gode at udfylde, men de påvirker ikke indeksering (kun hvordan dit snippet ser ud i søgeresultatet). Meta keywords er forældet og ignoreres af Google. Der findes også avancerede tags som meta http-equiv="refresh" (omdirigering) eller X-Robots-Tag header via server – men disse er sjældne og du vil nok vide hvis du bruger dem. Fokusér på de tre ovenstående (robots.txt, meta-robots, canonical), da de er de vigtigste.

Sådan kontrollerer og justerer du de tekniske elementer

Start med at bruge Search Console’s rapporter. I Dækning-rapporten vil du kunne se om nogle URL’er er “Ekskluderet – Blokeret af robots.txt” eller “Ekskluderet – Indekseret men blokeret” eller “Ekskluderet – Som følge af noindex-tag”. Disse indikationer fortæller klart, hvis dine sider er udelukket pga. tekniske opsætninger. Alternativt kan du manuelt kontrollere: Gå til dinhjemmeside.dk/robots.txt og skim den. Åbn en vigtig side i din browser, vis kildekode, og find “robots” for at se meta-robot tag, samt find “canonical”. Endelig kan du google “site:dinhjemmeside.dk” – hvis nogle sider ikke dukker op der, og du mistænker teknisk årsag, undersøg de nævnte ting. Mange CMS’er gør som sagt det rigtige per automatik, men især lige efter launch eller større redesign er det kritisk at dobbelttjekke disse indstillinger. Vi har set eksempler hvor et helt website lanceres men ved et uheld havde en Disallow: / stående i robots.txt fra testperioden – resultat: Ingen indeksering, indtil det blev opdaget og rettet.

Husk: Det allerførste du bør gøre hvis din side ikke indekseres, er at tjekke om et teknisk issue spænder ben – fx et noindex-tag eller en robots.txt blokering. Det er ofte synderen når folk spørger “hvorfor kan jeg ikke findes på Google?”.

For at opsummere: Teknisk SEO skal være i orden for at hurtig indeksering kan lade sig gøre. Google skal frit kunne crawle dine sider (robots.txt), have lov at indeksere dem (ingen noindex), og forstå hvis der er flere varianter (canonical). Heldigvis tager moderne CMS’er hånd om det meste, men ansvaret ligger hos dig for at overvåge det. Tag et kig i Search Console og ret eventuelle advarsler – så er du godt på vej.

8. Afsluttende guide: Trin-for-trin instruktion til hurtig indeksering

Vi har været omkring mange emner – her opsummerer vi de vigtigste trin i en prioriteret tjekliste. Følg disse skridt for at maksimere chancen for hurtig indeksering af din hjemmeside:

Opsæt Google Search Console og indsend dit sitemap: Verificér dit website i Google Search Console som noget af det første. Indsend derefter dit

sitemap.xmlvia GSC, så Google får en komplet URL-liste med det samme. GSC er din direkte linje til Google – udnyt det.Tjek for tekniske blokeringer (noindex/robots): Sikr dig, at intet forhindrer Google i at crawle og indeksere dine sider. Kontrollér din robots.txt for eventuelle

Disallow-regler, der dækker vigtige sektioner. Gennemgå også om der er sat<meta name="robots" content="noindex">på sider, der burde indekseres. Fjern eller ret disse blokeringer omgående, ellers nytter de følgende trin ikke noget.Brug URL-inspektion (GSC) på nye vigtige sider: For nye sider eller opdateringer du vil have indekseret lynhurtigt, brug URL-inspektionsværktøjet i Search Console. Indtast URL’en og klik “Anmod om indeksering”. Dette sender siden i kø til prioriteret crawl. (Begræns brugen til dine vigtigste sider for ikke at ramme kvoten.)

Sørg for intern linkning til nye sider: Tilføj links fra dine allerede indekserede sider til den nye side. Ideelt set link fra forsiden eller andre sider, der ofte besøges af Google. En logisk men robust intern linkstruktur guider Googlebot effektivt rundt. Undgå “forældreløse” sider uden links fra dit eget site.

Skaf eksterne links eller del på sociale medier: Hjælp Google med at opdage siden udefra. Del den nye URL på en offentlig Twitter, LinkedIn, eller andre sociale medier hvor Google kan crawle den. Endnu bedre – få et par eksterne backlinks fra relevante sider/blogs, hvis muligt. Eksterne links (især fra ofte-crawlede sites) vil pege Googlebot i retning af din side.

Opdater jævnligt og tilfør frisk indhold: Hold dit website aktivt ved løbende at udgive nyt indhold (blogindlæg, nyheder, produkter). Websites der ofte opdateres, bliver crawlet oftere af Google. Denne kontinuerlige strøm af nyt indhold øger chancen for at nye sider hurtigt fanges op. (Plus, det giver dig mulighed for at interne linke mellem nye og ældre sider.)

Optimer hastighed og mobilvenlighed (Core Web Vitals): Sikr at din side loader hurtigt og er mobiloptimeret. En hurtig side giver bedre brugeroplevelse og Google foretrækker at indeksere indhold der er teknisk velfungerende. Tjek PageSpeed Insights og fix større hastighedsproblemer. En mobilvenlig, lynhurtig side har bedre chancer i Google’s indeks end en langsom side.

Overvej en kort Google Ads-kampagne (valgfrit): Hvis det er afgørende at Google opdager din nye side ASAP, kan du køre en mindre Google Ads annonce med siden som landingsside. Dette kan få Google’s annonce-crawler til at besøge siden hurtigt. Det er ikke en nødvendig step for alle, men et ekstra trick i værktøjskassen. Selv en dags kampagne for et symbolsk beløb kan gøre en forskel i opstartsfasen.

Udnyt lokal SEO hvis relevant (GEO): Har du en lokal virksomhed, så glem ikke at optimere geografisk. Opret/optimer din Google My Business profil, så dit site er knyttet til et sted. Sørg for konsistent NAP-oplysning og lokale søgeord på dit site. Lokal SEO i sig selv fremskynder ikke indeksering globalt, men det sikrer at lokale søgere finder dig, og Google vil indeksere dine sider med korrekt lokal kontekst.

Prioritering

De første 5-6 trin ovenfor er de mest kritiske for selve indekseringshastigheden – især GSC-indsendelser, teknisk kontrol og linkning. Hastighedsoptimering og lokal/AEO er mere løbende strategier, der forbedrer din samlede SEO-sundhed.

Afslutningsvis, husk at der altid vil være en vis ventetid på indeksering – du kan kun gøre processen så hurtig som muligt. Med disse tiltag har du dog forkortet vejen betragteligt fra “udgivet” til “indekseret og synlig på Google”. Held og lykke med din indeksering og SEO!

Ønsker du mere viden? Opdag flere indlæg og artikler om SEO og linkbuilding ved at klikke her og vende tilbage til bloggens hovedside.